初探自我对战RL:梦想的启航 🚀

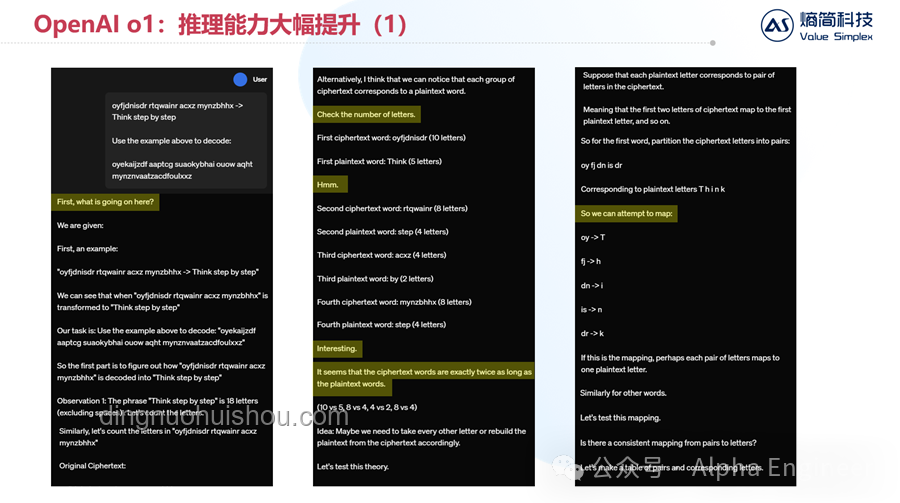

一切始于对OpenAI o1项目的深深着迷。作为AI爱好者,我渴望揭开那些让智能体在无监督环境下自我进化的神秘面纱。自我对战强化学习(Self-Play Reinforcement Learning),正是这片神秘领域中的璀璨明珠。它让智能体在与自己的对弈中不断试错、学习与超越,仿佛自然界的进化论在数字世界的完美复刻。

初识:理论与实践的碰撞 📚💥

一开始,我沉浸在自我对战RL的理论海洋中,AlphaZero、MuZero等经典论文成了我的枕边书。那些复杂的数学模型、精妙的状态空间表示以及令人叹为观止的学习效率,让我既兴奋又迷茫。如何将这些理论转化为实际代码,成为摆在我面前的第一道难关。

成功尝试:第一个自我对战模型 🏆

经过无数个日夜的奋战,我终于搭建起了第一个简化的自我对战RL模型。那是一个简化的围棋游戏环境,智能体从一无所知开始,通过不断地自我对战,逐渐学会了基本的策略与布局。那一刻,看着屏幕上的黑白棋子在智能体的指挥下交织出一幅幅精彩的棋局,我内心的激动难以言表。这不仅是技术上的突破,更是对自我对战RL理念的深刻理解与认同。

挫折与反思:成长的必经之路 🌧️💭

然而,好景不长,随着模型的复杂度提升,一系列问题接踵而至。内存泄漏、学习效率低下、过拟合……每一个问题都像是横亘在前进道路上的巨石,让我倍感挫败。我开始意识到,理论与实践之间,还有很长一段路要走。

失败案例:过拟合的陷阱 🕳️

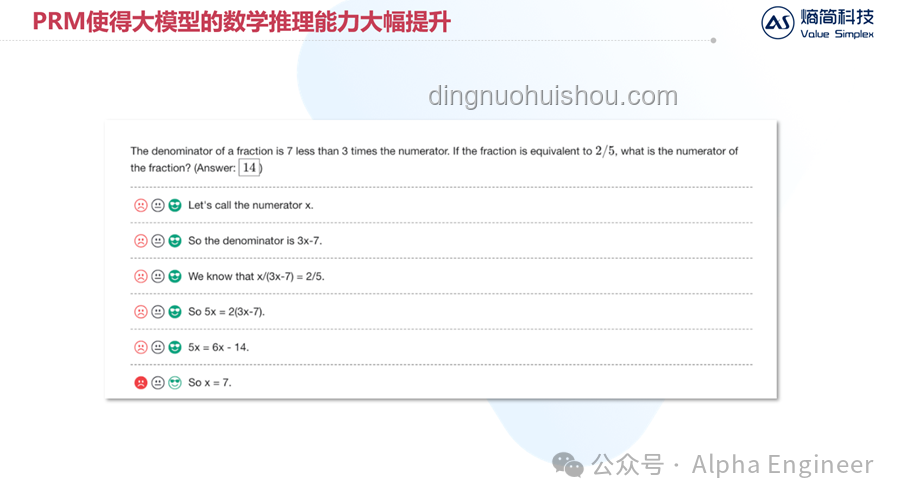

最令我难忘的,是一次因为过度追求胜率而导致的过拟合问题。智能体在特定的训练环境中表现得近乎完美,但一旦将其放入更广泛的测试环境,却表现得如同新手一般。这次教训深刻,让我认识到,泛化能力才是衡量一个模型真正价值的标准。

突破与成长:不断迭代与优化 🔧🚀

面对挑战,我没有选择退缩,而是开始了新一轮的迭代与优化。通过引入正则化技术、增加环境多样性、以及引入蒙特卡洛树搜索(MCTS)等方法,我逐步解决了过拟合、学习效率低下等问题。每一次的调整,都像是为智能体注入了一股新的活力,让它在自我对战的道路上越走越远。

成功案例:智能体的华丽蜕变 🦋

最终,经过无数次的尝试与调整,我的智能体实现了质的飞跃。它不仅能够在复杂的游戏环境中稳定胜出,更重要的是,它展现出了强大的泛化能力,能够在未见过的场景下做出合理的决策。那一刻,我仿佛看到了AI未来的无限可能。

心得体会:自我对战RL的深层魅力 💖🌟

回顾这段旅程,我深刻体会到了自我对战RL的独特魅力。它不仅仅是一种技术,更是一种哲学,一种让智能体在无监督环境中自我发现、自我成长的艺术。在这个过程中,我学会了如何平衡探索与利用、如何处理复杂系统的稳定性与多样性、以及如何在失败中汲取教训,不断前行。

给未来探索者的建议 💡💪

对于同样在这条道路上探索的朋友们,我有几点建议分享:

- 理论与实践相结合:理论是基石,但实践才是检验真理的唯一标准。不要害怕动手,将理论转化为代码,你会有意想不到的收获。

- 耐心与坚持:自我对战RL是一个长期且充满挑战的过程,耐心与坚持是通往成功的关键。

- 不断反思与优化:面对失败,不要气馁,而是要学会从中汲取教训,不断优化你的模型。

- 保持好奇心:AI领域日新月异,保持对新技术、新理论的好奇心,会让你在这条道路上走得更远。

Q&A:你可能关心的问题 🤔

Q:自我对战RL适合哪些领域? A:自我对战RL广泛应用于棋类游戏、电子竞技、自动驾驶模拟等领域,只要满足环境可模拟、目标可量化等条件,都有可能成为自我对战RL的用武之地。 Q:如何避免过拟合? A:避免过拟合的关键在于增加环境多样性、引入正则化技术、以及使用dropout等策略,同时要注意监控模型在未见数据上的表现。 在OpenAI o1自我对战RL技术路线的推演过程中,我收获了知识、技能,更重要的是,我收获了成长与自信。希望这篇分享能够激励更多的AI爱好者,勇敢踏上这条充满挑战与魅力的探索之旅。🚀💖

文章评论 (5)

发表评论